近年來,人工智慧(AI)技術突飛猛進,尤其是在深度學習、雲端運算、超級電腦(HPC)等領域,運算能力的需求激增。這使得高效能伺服器的功耗與散熱成為極具挑戰性的問題。根據台灣經濟部產業技術司的報導,當前高階AI晶片的功耗已達1000W,但傳統氣冷散熱的上限僅約750W,顯示氣冷技術難以應對AI伺服器的散熱需求。為了解決這個問題,各大企業開始積極發展液冷技術,其中水冷式水幫浦(Liquid Cooling Pump)成為AI伺服器與資料中心散熱的關鍵方案。水冷技術不僅提升散熱效率,還可降低能源消耗、減少碳排放,符合綠色運算(Green Computing)的發展趨勢。本篇文章將深入探討台灣AI產業發展趨勢、各類伺服器散熱方式的比較,並重點分析水幫浦散熱在資料中心與AI伺服器的應用與優勢。

大綱

一、台灣AI產業的未來發展

二、AI運算的領域應用

三、AI伺服器散熱策略:解析三大關鍵技術

四、伺服器液冷散熱的市場痛點

五、伺服器冷去用水幫浦解決方案

一、台灣AI產業的未來發展

台灣是全球半導體與AI硬體設備的領導者之一。AI應用的市場需求迅速增長,帶動高效能運算(HPC)與資料中心的發展。AI產業的主要趨勢包括:

• 高階AI晶片功耗持續提升:AI訓練與推論模型持續進步,需要更高功耗的GPU、TPU與ASIC晶片,NVIDIA、AMD與Intel等公司的AI專用晶片功耗已突破1000W,未來散熱需求更為嚴峻。

• 伺服器密度提高:AI伺服器逐漸向高密度發展,如機架伺服器(Rack Server)、GPU伺服器等,導致熱量累積更加嚴重。

• 資料中心的電力與冷卻挑戰:全球大型資料中心的PUE(Power Usage Effectiveness)指數受到關注,業界普遍朝PUE<1.3的目標前進,減少能源浪費。

未來發展關鍵: 隨著AI運算的推動,水冷與浸沒式冷卻技術成為未來發展趨勢,台灣的散熱供應鏈,包括水幫浦、冷卻液技術、液冷機櫃等相關技術,也將迎來龐大的市場機會。

二、AI運算的領域應用

AI運算應用領域廣泛,以下是主要的計算領域:

• 超級電腦(Supercomputing):用於處理複雜的科學計算和模擬,如氣象預測和基因組研究。

• 高效能計算(HPC):支援大型數據分析和工程模擬,應用於石油勘探和金融建模等領域。

• AI運算(AI Training & Inference):深度學習、大型語言模型(LLM)訓練,應用於語音識別、推論和圖像分類等。

• 雲端運算(Cloud Computing):AWS、Google Cloud、Azure等提供AI推論服務,提供彈性的計算資源,以及各種AI應用的部署和擴展。

• 伺服器主機(Server Hosting):支援企業級應用和數據庫管理,企業級IT基礎建設,如資料庫管理、ERP系統,確保高可用性和可靠性。

• 邊緣運算(Edge Computing):在靠近數據源的位置進行計算,降低延遲,應用於物聯網(IoT)和智慧工廠、智慧城市等領域。

• 新能源與電動車:AI控制電池,技術優化能源管理、智慧駕駛,車輛控制系統,提高效率和安全性。 這些領域對於高效散熱解決方案的需求極為迫切,液冷技術成為關鍵。

三、AI伺服器散熱策略:解析三大關鍵技術

隨著AI晶片運算效能的提升,散熱問題日益嚴峻,選擇合適的散熱技術成為確保伺服器穩定運行的關鍵。 人工智慧廣泛應用於資料蒐集、處理與高效運算,大量數據計算不僅提升了晶片效能需求,也伴隨著能耗與發熱量的急劇上升。

隨著運算能力的飛躍,單一晶片的熱能與功耗不斷攀升。雖然晶片發熱是運作過程中的必然現象,但若未能有效管理,過高的溫度將影響晶片的壽命、穩定性與可靠性。最直接的影響包括:高溫導致運算效能下降、資料處理速度減緩,甚至縮短使用壽命或引發過熱故障。因此,如何透過高效散熱技術來維持晶片穩定運行,成為AI伺服器設計的重要課題。

• 氣冷式散熱(Air Cooling):一般企業機房最廣泛使用的散熱方法

熱交換原理:利用風扇和散熱器將熱能從伺服器內部產生的熱量帶離機殼,再由機房空調系統排放至外部環境,以維持運算設備的穩定運行。

優勢

✅ 初期建置成本低:無需額外改造機房,適合傳統數據中心。

✅ 維護便利:運行架構簡單,管理與維修門檻低。

劣勢

❌ 散熱能力有限:依賴風扇與冷氣系統,能耗高,數據中心PUE(Power Usage Effectiveness)通常在 1.5-2.0 之間。

❌ 無法滿足高功耗需求:AI晶片與HPC(高效能運算)系統的功耗不斷提升,傳統氣冷技術已達極限,無法有效散熱。根據經濟部產業技術司的報告,高階AI晶片的散熱需求已超過 1000W,而氣冷方案的極限約為 750W。

❌ 噪音與震動影響:大量風扇運行產生高頻震動與噪音,可能影響伺服器穩定性與工作環境品質。

• 水冷式散熱(DLC,Direct liquid cooling):提升散熱效率,降低能耗

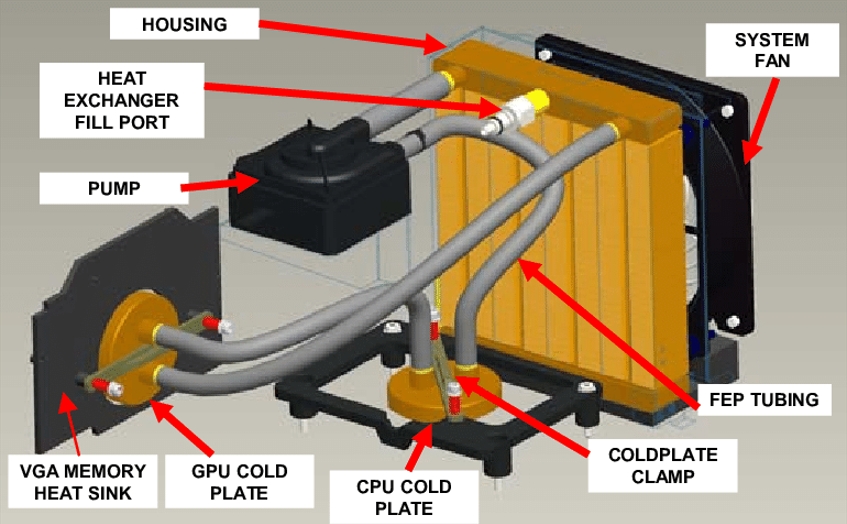

水冷技術透過液體(如去離子水或專用冷卻液)作為傳熱介質,透過冷卻管線將熱量傳導至外部散熱裝置,依據排熱方式可分為「水對氣」(Liquid to Air)與「水對水」(Liquid to Liquid)兩種方案。

水冷裝置的工作原理是透過幫浦頭與CPU的接觸,冷水流經幫浦頭,透過水幫浦的運作轉變成熱水。

熱水流向冷散熱器,將熱量傳遞給內藏有大量鋁製翅片的冷散熱器 ,然後變成冷水返回幫浦頭。

水對氣(Liquid to Air)

熱交換原理 冷卻液將伺服器內部熱量帶至機櫃後方的風扇背門,再透過風扇將熱量釋放至空氣中,以達成散熱效果。

優勢

✅ 易於部署:可在現有氣冷機房中升級,不需大幅改造伺服器架構。

✅ 較高能效表現:數據中心PUE可降至 1.1-1.2,相較氣冷大幅降低能耗。

劣勢

❌ 仍需風扇輔助:額外的風扇運行可能帶來噪音干擾。

水對水(Liquid to Liquid)

熱交換原理 伺服器內部冷卻液經由管線與機房內固定的冷卻系統相連,透過水循環機制統一排熱,將熱量傳導至外部冷卻設備(如水塔或冰水主機)。

優勢

✅ 更高散熱效能:比水對氣方案更進一步提升散熱效率,能有效應對高功耗AI伺服器。

✅ 極致能效:數據中心PUE可降至 1.05-1.1,顯著降低運營成本。

劣勢

❌ 高建置成本:需規劃專用水冷機房,額外配置冷卻設備,初期投資較高。

❌ 機房改造需求高:無法直接升級氣冷機房,需額外佈署冷卻管線與水處理設備。

水冷技術因其優越的散熱能力,已成為高功耗AI伺服器與雲端數據中心的重要選擇。例如,工研院與Intel合作開發千瓦級AI伺服器水冷技術,提供高效能、高穩定性的解決方案。

• 浸沒式液冷(Immersion Cooling):極致散熱方案

熱交換原理 將伺服器完全浸沒於介電液(不導電冷卻液)中,透過液體直接與電子元件接觸交換熱量,藉由相變化或循環機制將熱能帶離設備。

優勢

✅ 最高效能散熱:熱傳導效率極高,數據中心PUE可低至 1.05,大幅降低能耗。

✅ 適用高密度伺服器:可在有限空間內配置更高功率的伺服器,適合AI運算、HPC等應用。

✅ 低噪音、低震動:無需風扇,運行更為安靜,並減少機械震動對設備的影響。

劣勢

❌ 基礎設施成本高:需建置專屬機房、液冷槽與冷卻液處理設備,初期投資昂貴。

❌ 維護與相容性挑戰:介電液可能影響部分伺服器零組件,需進行 3-5年長期相容性測試,且不同世代的設備需重新評估冷卻液適用性。

❌ 技術成熟度待提升:目前仍處於技術發展階段,伺服器業者需不斷測試與驗證新材質的適應性,才能確保長期穩定運行。 浸沒式液冷技術雖然擁有卓越的散熱效能,但仍需克服材料相容性、維護成本與技術標準化等挑戰。然而,隨著AI運算需求不斷提升,該技術將成為未來高效能數據中心的重要選項。

| 散熱方式 | 解熱效率 | 電力使用效率 (PUE) | 成本 | 基礎建設需求 |

|---|---|---|---|---|

| 氣冷 (Air Cooling) | ~850W | 1.4~1.6 | 1000~5000 | 無需額外改造機房,適合傳統數據中心 |

| 水冷/水對氣(Liquid to Air) | 850~1200W | 1.1~1.2 | 3~5萬,中等 | 適用於現有氣冷機房改造,可在原先的機櫃上加上水冷背門與風扇即可運作 |

| 水冷/水對水(Liquid to Liquid) 用於高功耗AI伺服器 | 1200~1500W | 1.05~1.1 | 3~5萬,高 | 需搭配中央液冷設施,機房預留冷卻水管線,無法輕易改建 |

| 浸沒式/單向 (Immersion Cooling) 支援超高功耗伺服器 | 1500W+ | 1.03~1.05 | 20~30萬,高 | 建置成本高但能耗成本低,需特殊設計冷卻管路 |

| 浸沒式/雙向 (Immersion Cooling) 支援超高功耗伺服器 | 1500W+ | 1.02~1.005 | 20~30萬,極高 | 需機房專屬設計,適用於新建資料中心 |

*PUE (Power Usage Effectiveness,電力使用效率)是計算資料中心節能省電的標準,計算的方式是資料中心的「總用電量」與「供應IT設備的電量」之比。PUE值越低,代表提房空調冷卻時所耗的電力就會更少,理想的PUE比率率為1.0,意即資料中心所提供的電完全用於電腦運算

四、伺服器液冷散熱的市場痛點

隨著AI運算與高效能運算(HPC)技術的發展,傳統氣冷散熱已經無法應對日益增加的功耗與熱量管理需求,液冷技術逐漸成為主流。然而,在1U/2U伺服器中導入液冷方案仍面臨諸多挑戰:

1. 設計空間受限: 現有伺服器機櫃內部結構大多基於氣冷設計,增加液冷系統將面臨空間佈局的限制。例如,1U伺服器的高度僅為4.445cm,2U伺服器也僅有8.89cm,要在有限空間內集成冷卻液流道、冷板與水幫浦,對設計要求極為嚴苛。

2. 密封與防漏風險: 伺服器內部核心元件(如CPU、GPU)對液體極為敏感,一旦發生洩漏,可能導致短路甚至整機報廢。因此,液冷系統的密封性與防漏設計至關重要,需確保水泵、管路與接頭的高氣密性,以降低風險。

3. 散熱效率與穩定性: 根據業界統計,超過55%的伺服器故障與熱管理不當有關。當晶片溫度超過70℃,每升高10℃,其可靠性將降低50%。若水幫浦性能不佳或流體循環設計不當,將可能造成局部過熱,影響運算效能,甚至導致系統頻繁當機。

五、伺服器冷去用水幫浦解決方案

為了應對上述市場挑戰,郁冠 Pump 針對伺服器液冷應用研發了DC-C08-BL 微型水幫浦,提供高效、穩定且符合伺服器機櫃限制的冷卻解決方案。

1. 超薄緊湊設計,適用1U/2U伺服器

o 微型水幫浦厚度僅36mm,可靈活適應狹小空間。

o 幫浦與冷板一體化方案可客製化設計,有效提升資料中心機櫃內部空間利用率。

2. 高氣密防漏設計,確保系統安全性

o 採用進口PPS高強度材料與高精度模具製造。

o 透過法國進口氣密性檢測設備進行100%嚴格測試,確保防漏能力。

3. 高耐磨軸承與懸浮轉子技術,延長使用壽命

o 內建高精度陶瓷軸與進口石墨襯套,大幅降低磨損與故障率。

o 轉子懸浮技術確保長期運行穩定,減少停機維護成本。 o 馬達壽命 >20,000 hrs

4. 智慧化監控與調速功能,最佳化散熱效能

o 最大流量達8L/min,最大揚程5M,確保高效冷卻能力。

o 內建智慧晶片,可支援PWM調速、訊號回饋,便於即時監控與動態調節水流,確保伺服器長時間穩定運行。

郁冠DC-C08-BL伺服器水幫浦 採用國際標準級離心式液體幫浦浦,具備高流量、高揚程、低功耗等特性,同時支援多種控制模式(PWM、類比訊號等),能夠精確調節水泵轉速,確保伺服器機櫃維持最佳溫度。

總結

隨著AI運算時代的來臨,氣冷散熱技術已經無法滿足高效能伺服器的需求,而液冷技術成為未來趨勢。選擇高效、穩定、低能耗的水幫浦解決方案,不僅能提升伺服器的運行效率,更能大幅降低PUE(能源使用效率)指標,助力企業打造更綠色節能的資料中心。

郁冠高效液冷散熱解決方案專家,立即聯繫我們,為您的伺服器提供最優質的水冷解決方案!